Die ethischen Dimensionen der Robotik

Mit dem rasanten Fortschritt in der Robotik und künstlichen Intelligenz stehen wir vor einer Vielzahl ethischer Fragen und moralischer Dilemmata, die weit über technische Herausforderungen hinausgehen. Autonome Systeme treffen zunehmend eigenständige Entscheidungen, die direkten Einfluss auf menschliches Leben und Wohlbefinden haben können. Diese Entwicklung wirft fundamentale Fragen auf: Welche Werte sollten in diese Systeme einprogrammiert werden? Wer trägt die Verantwortung für ihre Entscheidungen? Und wie bewahren wir menschliche Würde und Autonomie in einer zunehmend automatisierten Welt?

In diesem Artikel betrachten wir die wichtigsten ethischen Herausforderungen der Robotik und autonomen Systeme und diskutieren Ansätze, wie diese Technologien zum Wohle der Menschheit gestaltet werden können.

Grundlegende ethische Problemfelder in der Robotik

1. Autonomie und Entscheidungsfindung

Je autonomer Roboter werden, desto komplexere Entscheidungen treffen sie selbstständig. Bei selbstfahrenden Autos etwa können in Unfallsituationen ethische Dilemmata entstehen, die traditionell als "Trolley-Probleme" bekannt sind: Soll das Fahrzeug beispielsweise einen Kurs beibehalten, der mehrere Fußgänger gefährdet, oder ausweichen und dabei möglicherweise die Insassen des Fahrzeugs in Gefahr bringen?

Solche Entscheidungen erfordern eine Abwägung von Werten, die bisher dem menschlichen Urteilsvermögen vorbehalten war. Die Programmierung dieser Wertehierarchien wirft schwierige Fragen auf: Sollten alle Menschenleben gleich gewichtet werden? Dürfen demografische Faktoren wie Alter eine Rolle spielen? Und wer sollte über diese Grundsätze entscheiden – Ingenieure, Ethiker, Politiker oder die Gesellschaft als Ganzes?

Visualisierung eines ethischen Dilemmas für ein autonomes Fahrzeug

Visualisierung eines ethischen Dilemmas für ein autonomes Fahrzeug

2. Verantwortung und Haftung

Mit zunehmender Autonomie von Robotern wird die Zuschreibung von Verantwortung komplexer. Wenn ein autonomes System eine schädliche Entscheidung trifft, wer trägt die Verantwortung? Der Hersteller, der Programmierer, der Eigentümer oder der Nutzer? Oder kann man in irgendeiner sinnvollen Weise von einer "Verantwortung" des Systems selbst sprechen?

Diese Fragen haben weitreichende rechtliche Implikationen. Traditionelle Haftungsmodelle basieren auf menschlichem Handeln und Unterlassen. Bei Systemen, die auf komplexen Algorithmen und maschinellem Lernen basieren, kann es jedoch schwierig sein, kausale Zusammenhänge zwischen Programmierung und spezifischen Entscheidungen herzustellen, besonders wenn das System aus Erfahrungen lernt und sich weiterentwickelt.

3. Privatsphäre und Überwachung

Roboter und intelligente Systeme sammeln enorme Mengen an Daten über ihre Umgebung und die Menschen, mit denen sie interagieren. Dies wirft Bedenken hinsichtlich Privatsphäre und Überwachung auf. Haushaltsroboter haben Zugang zu intimen Bereichen unseres Lebens, während öffentlich eingesetzte autonome Systeme das Potenzial für Massenüberwachung bieten.

Die Balance zwischen nützlicher Datensammlung für verbesserte Funktionalität und dem Schutz der Privatsphäre stellt eine zentrale ethische Herausforderung dar. Besonders problematisch wird dies, wenn die gesammelten Daten für kommerzielle Zwecke genutzt oder an Dritte weitergegeben werden.

4. Arbeitsmarkt und soziale Gerechtigkeit

Die zunehmende Automatisierung durch Robotik hat tiefgreifende Auswirkungen auf den Arbeitsmarkt. Während sie einerseits gefährliche, monotone und belastende Tätigkeiten übernehmen kann, führt sie andererseits potenziell zum Verlust von Arbeitsplätzen und erfordert neue Qualifikationen von Arbeitnehmern.

Die ethische Herausforderung besteht darin, sicherzustellen, dass die Vorteile der Automatisierung gerecht verteilt werden und nicht zu einer Vertiefung sozialer Ungleichheiten führen. Dies wirft Fragen nach Umschulungsprogrammen, sozialen Sicherheitsnetzen und möglicherweise grundlegenden Änderungen in unseren wirtschaftlichen Systemen auf, wie etwa die Idee eines bedingungslosen Grundeinkommens.

"Die Ethik der Robotik ist nicht nur eine Frage des richtigen Programmierens, sondern eine gesellschaftliche Aufgabe, die fundamentale Werte wie Menschenwürde, Gerechtigkeit und Autonomie berührt." - Dr. Julia Hoffmann

Spezifische Anwendungsbereiche und ihre ethischen Herausforderungen

1. Medizinische Robotik

Im medizinischen Bereich können Roboter und KI-Systeme die Diagnose und Behandlung verbessern, aber werfen auch spezifische ethische Fragen auf. Wer trägt die Verantwortung, wenn ein diagnostisches KI-System einen Fehler macht? Wie wird informierte Einwilligung gestaltet, wenn Algorithmen Behandlungsentscheidungen beeinflussen? Und wie stellen wir sicher, dass der menschliche Kontakt, der für viele Patienten essentiell ist, nicht verloren geht?

Besonders in der Pflege müssen wir abwägen zwischen technischer Effizienz und menschlicher Zuwendung. Pflegeroboter können körperliche Belastungen reduzieren und kontinuierliche Überwachung bieten, aber sie können nicht die emotionale Verbindung ersetzen, die menschliche Pflegekräfte bieten.

2. Militärische Robotik

Autonome Waffensysteme stellen eine der kontroversesten Anwendungen der Robotik dar. Die Möglichkeit, dass Maschinen eigenständig über den Einsatz tödlicher Gewalt entscheiden könnten, wirft schwerwiegende ethische und völkerrechtliche Bedenken auf.

Befürworter argumentieren, dass solche Systeme potenziell präziser und weniger emotional handeln könnten als Menschen und damit zivile Opfer reduzieren könnten. Kritiker hingegen betonen, dass die Entscheidung über Leben und Tod niemals an Maschinen delegiert werden sollte und dass eine Automatisierung des Krieges die Schwelle für bewaffnete Konflikte senken könnte.

Demonstration gegen autonome Waffensysteme vor den Vereinten Nationen

Demonstration gegen autonome Waffensysteme vor den Vereinten Nationen

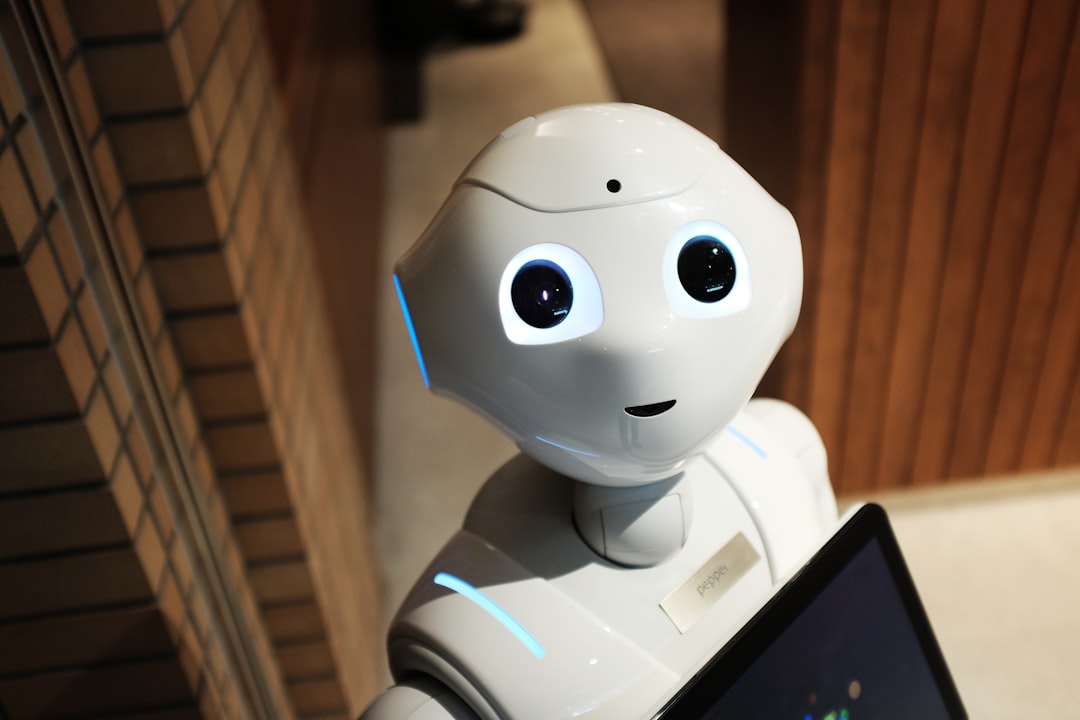

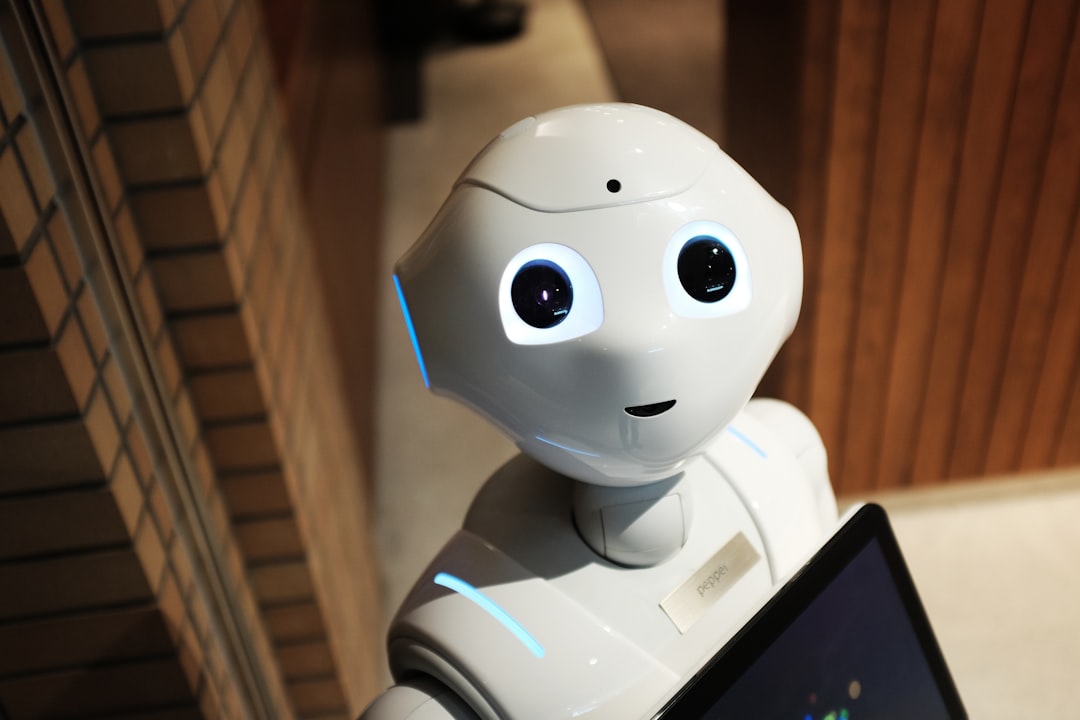

3. Soziale Roboter

Soziale Roboter, die für die Interaktion mit Menschen in alltäglichen oder therapeutischen Kontexten entwickelt werden, werfen Fragen nach Authentizität und Täuschung auf. Wenn ein Roboter menschenähnliches Verhalten simuliert und emotionale Bindungen hervorruft, kann dies als Form der Täuschung betrachtet werden, besonders bei vulnerablen Gruppen wie Kindern oder älteren Menschen mit kognitiven Einschränkungen.

Gleichzeitig können diese Roboter wertvolle Dienste leisten, etwa in der Unterstützung von Menschen mit Autismus oder in der Betreuung von Demenzpatienten. Die ethische Herausforderung besteht darin, eine Balance zu finden zwischen den therapeutischen Vorteilen und der Wahrung von Authentizität und Würde in menschlichen Beziehungen.

4. Überwachung und Sicherheit

Roboter und KI-Systeme werden zunehmend für Überwachungs- und Sicherheitsanwendungen eingesetzt, von Gesichtserkennungssystemen in öffentlichen Räumen bis zu Drohnen für die Grenzüberwachung. Diese Anwendungen versprechen erhöhte Sicherheit, stellen aber auch ernsthafte Bedrohungen für bürgerliche Freiheiten und Privatsphäre dar.

Die ethische Abwägung zwischen Sicherheit und Freiheit ist nicht neu, gewinnt aber durch die beispiellose Überwachungskapazität moderner Technologien neue Dimensionen. Besondere Bedenken bestehen hinsichtlich algorithmic bias - der Gefahr, dass Vorurteile in den Trainingsdaten von KI-Systemen zu diskriminierenden Ergebnissen führen können.

Ansätze zur ethischen Gestaltung der Robotik

1. Ethische Designprinzipien

Ein grundlegender Ansatz ist die Integration ethischer Überlegungen direkt in den Designprozess - oft als "Ethics by Design" bezeichnet. Dies beinhaltet die frühzeitige Identifikation potenzieller ethischer Probleme und ihre Berücksichtigung bei der Konzeption und Entwicklung robotischer Systeme.

Konkrete Prinzipien könnten Transparenz (Nutzer sollten verstehen können, wie und warum ein Roboter Entscheidungen trifft), Kontrolle (Menschen sollten die Möglichkeit haben, autonome Systeme zu übersteuern), Nichtdiskriminierung und Datenschutz umfassen. Durch sorgfältige Gestaltung können einige ethische Probleme gemildert oder vermieden werden, bevor sie entstehen.

2. Regulatorische Rahmenbedingungen

Angesichts der gesellschaftlichen Tragweite robotischer Technologien ist eine angemessene Regulierung unerlässlich. Dies kann von Sicherheitsstandards und Haftungsregeln bis hin zu spezifischen Verboten oder Einschränkungen bestimmter Anwendungen reichen.

Die Herausforderung besteht darin, Regulierungen zu entwickeln, die einerseits robust genug sind, um Menschen zu schützen, andererseits aber flexibel genug, um Innovation nicht zu ersticken. Zudem erfordert die globale Natur der Technologieentwicklung internationale Koordination, um einen "Wettlauf nach unten" bei Sicherheits- und Ethikstandards zu vermeiden.

3. Partizipative Technikgestaltung

Die Einbeziehung verschiedener Stakeholder - einschließlich potenzieller Nutzer, betroffener Gemeinschaften und Experten aus verschiedenen Disziplinen - in den Entwicklungsprozess kann helfen, verschiedene Perspektiven und Bedenken zu berücksichtigen.

Partizipative Ansätze können dazu beitragen, dass Robotertechnologien den tatsächlichen Bedürfnissen und Werten der Menschen entsprechen, die mit ihnen interagieren werden, und nicht nur den Annahmen von Entwicklern oder kommerziellen Interessen.

4. Ethische Bildung und interdisziplinäre Zusammenarbeit

Eine langfristige Strategie ist die Integration ethischer Bildung in die Ausbildung von Ingenieuren, Programmierern und anderen Technikexperten. Ein Verständnis für ethische Prinzipien und die gesellschaftlichen Auswirkungen von Technologie sollte ein zentraler Bestandteil technischer Studiengänge sein.

Gleichzeitig ist eine engere Zusammenarbeit zwischen technischen Disziplinen und Geistes- und Sozialwissenschaften erforderlich, um die komplexen ethischen, sozialen und rechtlichen Fragen zu adressieren, die mit fortschrittlicher Robotik einhergehen.

Philosophische Perspektiven auf Mensch-Roboter-Beziehungen

1. Die Natur des Bewusstseins und der Moral

Die Entwicklung immer sophistizierterer KI-Systeme wirft fundamentale Fragen über die Natur von Bewusstsein, Intelligenz und moralischem Status auf. Ab welchem Punkt, wenn überhaupt, könnten wir Robotern einen moralischen Status zuschreiben? Was würde es bedeuten, wenn Maschinen ein Bewusstsein oder subjektives Erleben entwickeln würden?

Diese philosophischen Fragen mögen derzeit noch spekulativ erscheinen, doch mit fortschreitender Technologie könnten sie praktische Relevanz erlangen. Sie zwingen uns, unsere Annahmen über menschliche Einzigartigkeit und die Grundlagen moralischer Berücksichtigung zu überdenken.

2. Technologischer Determinismus vs. menschliche Gestaltungsmacht

Eine wichtige philosophische Debatte betrifft das Verhältnis zwischen technologischer Entwicklung und menschlicher Handlungsfähigkeit. Der technologische Determinismus suggeriert, dass Technologie einer inneren Logik folgt und unvermeidliche gesellschaftliche Auswirkungen hat. Diesem Standpunkt steht die Überzeugung gegenüber, dass Menschen als Individuen und Gesellschaften die Macht haben, Technologie bewusst zu gestalten und einzusetzen, um gewünschte Ziele zu erreichen.

Diese Spannung ist besonders relevant für die Robotik, wo oft der Eindruck entsteht, dass wir einer unaufhaltsamen Automatisierungswelle ausgesetzt sind. Eine ethisch reflektierte Herangehensweise erfordert die Erkenntnis, dass wir aktiv Entscheidungen darüber treffen können und sollten, welche Technologien wir entwickeln und wie wir sie einsetzen.

3. Der Wert menschlicher Arbeit und Beziehungen

Die zunehmende Automatisierung zwingt uns, über den Wert menschlicher Arbeit und Beziehungen jenseits instrumenteller Effizienz nachzudenken. Welche Arten von Arbeit sollten Menschen vorbehalten bleiben, nicht weil Maschinen sie nicht übernehmen könnten, sondern weil etwas Wertvolles verloren ginge, wenn sie es täten?

Ähnlich müssen wir reflektieren, welche Rolle Technologie in menschlichen Beziehungen spielen sollte. Können technologisch vermittelte Interaktionen authentische menschliche Verbindungen ersetzen oder ergänzen? Diese Fragen berühren tiefgreifende Aspekte unseres Selbstverständnisses als soziale Wesen.

Zukunftsaussichten und Handlungsempfehlungen

Die ethischen Herausforderungen der Robotik werden mit zunehmender technologischer Entwicklung komplexer und dringlicher. Um eine verantwortungsvolle Gestaltung dieser Technologien sicherzustellen, empfehlen sich folgende Ansätze:

- Proaktive ethische Reflexion: Anstatt auf Probleme zu reagieren, nachdem sie aufgetreten sind, sollten ethische Überlegungen von Beginn an in Forschungs- und Entwicklungsprozesse integriert werden.

- Inklusive Entscheidungsprozesse: Die Entscheidungen über die Gestaltung und Regulierung von Robotertechnologien sollten demokratisch und inklusiv sein, unter Einbeziehung verschiedener gesellschaftlicher Gruppen und Perspektiven.

- Internationale Zusammenarbeit: Angesichts der globalen Natur der Technologieentwicklung ist eine internationale Koordination von Standards und Regulierungen unerlässlich.

- Kontinuierliche Bewertung und Anpassung: Ethische Herausforderungen entwickeln sich mit der Technologie weiter. Eine kontinuierliche Bewertung und Anpassung von Richtlinien und Praktiken ist erforderlich.

- Bildung und öffentlicher Diskurs: Ein informierter öffentlicher Diskurs über die ethischen Dimensionen der Robotik erfordert Bildungsmaßnahmen und transparente Kommunikation.

Fazit

Die Roboterethik steht an der Schnittstelle von Technologie, Philosophie, Recht und Gesellschaft. Sie erfordert eine sorgfältige Abwägung zwischen den potenziellen Vorteilen autonomer Systeme und den Risiken, die sie für menschliche Werte wie Autonomie, Privatsphäre, Würde und Gerechtigkeit darstellen können.

Die Art und Weise, wie wir diese ethischen Herausforderungen angehen, wird maßgeblich darüber entscheiden, ob Robotertechnologien zu einer gerechteren, sichereren und menschenwürdigeren Zukunft beitragen oder bestehende Probleme verschärfen. Es liegt in unserer kollektiven Verantwortung, dafür zu sorgen, dass der technologische Fortschritt im Einklang mit unseren tiefsten menschlichen Werten steht.

Bleiben Sie mit RoboFutur auf dem Laufenden über die ethischen Dimensionen der Robotik und tragen Sie zum Diskurs über eine verantwortungsvolle Technologieentwicklung bei.

Kommentare (9)

Prof. Dr. Robert Bauer

11. September 2023, 14:05Ein hervorragender Artikel, der die komplexen ethischen Fragen der Robotik differenziert beleuchtet. Ich möchte einen Aspekt ergänzen: Die kulturellen Unterschiede im Umgang mit Robotik und KI. Während in Japan beispielsweise eine größere Offenheit gegenüber Robotern im Pflegebereich besteht, sind westliche Gesellschaften oft skeptischer. Diese kulturellen Perspektiven sollten in der globalen Diskussion um Roboterethik mehr Beachtung finden.

Dr. Julia Hoffmann

11. September 2023, 16:18Vielen Dank für diesen wichtigen Hinweis, Prof. Bauer! Sie sprechen einen entscheidenden Punkt an. Die kulturellen Unterschiede in der Wahrnehmung und Akzeptanz von Robotern sind tatsächlich signifikant und verdienen mehr Aufmerksamkeit. Diese Unterschiede sollten uns auch daran erinnern, dass ethische Frameworks nicht universal sind und wir einen kultursensiblen Ansatz in der globalen Robotikregulierung benötigen. Ich plane, diesen Aspekt in einem Folgeartikel ausführlicher zu behandeln.

Lisa Neumann

10. September 2023, 09:31Als Informatikstudentin finde ich die ethischen Dimensionen oft zu wenig in unserem Studium vertreten. Haben Sie Empfehlungen, wie wir als angehende Entwickler uns besser mit diesen Fragen auseinandersetzen können? Gibt es gute Ressourcen oder Kurse zu diesem Thema?

Hinterlassen Sie einen Kommentar